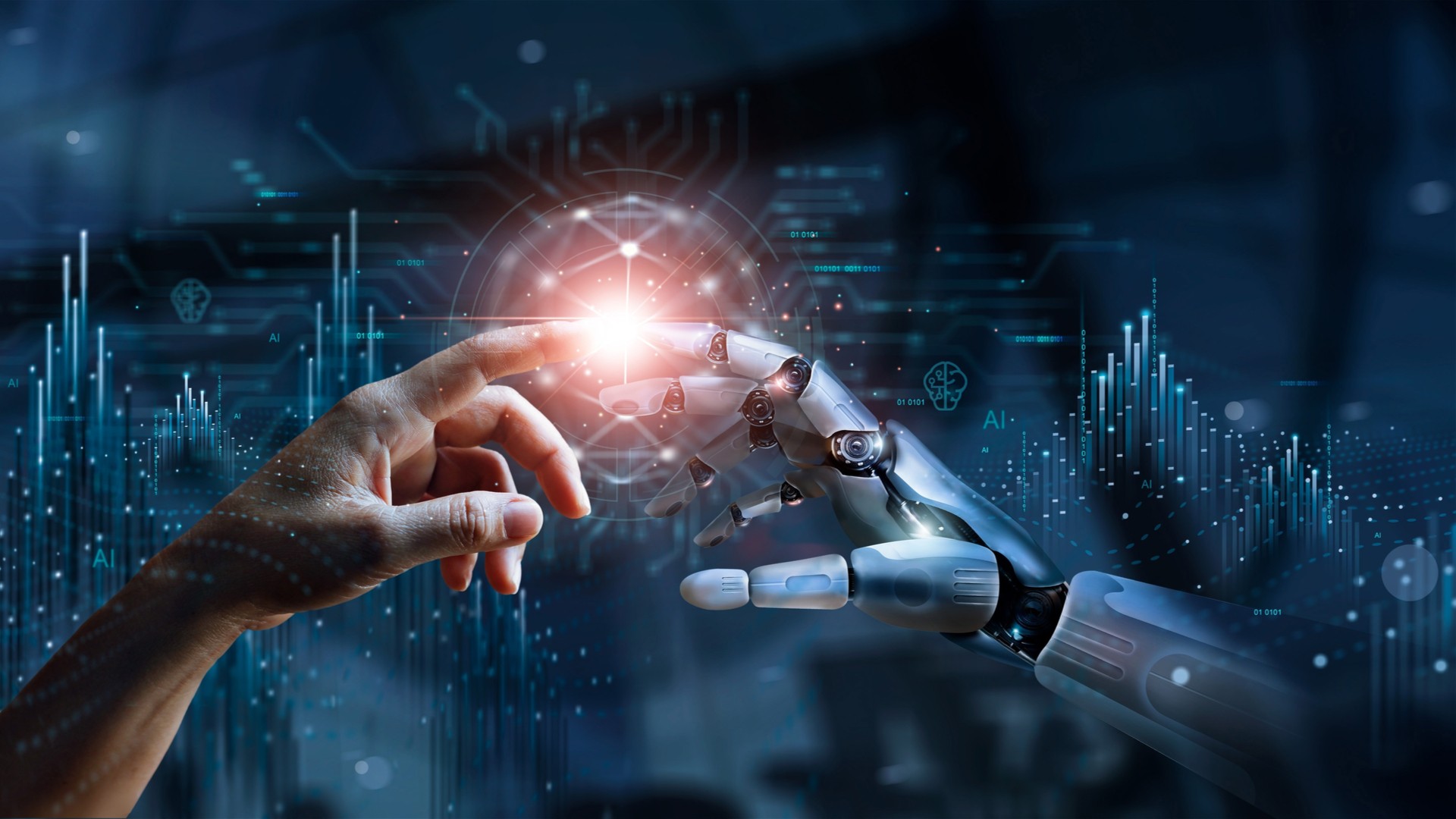

L’idea che il digitale e l’Intelligenza Artificiale – come ho evidenziato in un articolo precedente (leggi) – stiano trasformando l’essenza stessa della realtà, oltre che la nostra capacità di comprenderla, solleva una serie di questioni etiche e filosofiche di enorme portata. Non si tratta solo dell’uso di nuove tecnologie, ma di una ridefinizione della stessa ontologia del mondo: il modo in cui il reale viene esperito, creato e controllato. Le implicazioni etiche e filosofiche riguardano la nostra comprensione del potere, della responsabilità, della verità e dell’autenticità.

Uno dei primi problemi che emergono riguarda la natura stessa della verità. Se il digitale è in grado di creare mondi e realtà alternative, come possiamo distinguere ciò che è vero da ciò che non lo è? La proliferazione di deepfake, modelli digitali e simulazioni sofisticate porta a una crisi del concetto di verità. In un mondo in cui l’Intelligenza Artificiale può generare immagini, testi e persino video credibili e difficilmente distinguibili da quelli reali, la linea di demarcazione tra verità e menzogna diventa sempre più sottile.

Questa crisi ha ripercussioni importanti su diverse sfere della nostra vita sociale. Ad esempio, nel contesto politico, la manipolazione della realtà può avere un impatto devastante. Le campagne di disinformazione basate su contenuti digitali falsi, ma convincenti, possono influenzare l’opinione pubblica e destabilizzare le democrazie. Allo stesso tempo, sul piano individuale, la possibilità di vivere in una realtà simulata solleva interrogativi sul significato dell’autenticità e della fiducia nelle nostre percezioni.

Un’altra questione di rilievo è la responsabilità morale degli agenti artificiali. L’AI, soprattutto quando è in grado di prendere decisioni autonomamente, introduce un nuovo soggetto morale nella scena etica. Se un algoritmo compie una scelta che ha conseguenze negative – ad esempio, in ambito sanitario, giudiziario o economico – chi ne è responsabile? Si tratta di una questione complessa, poiché gli algoritmi non sono dotati di coscienza o intenzionalità come gli esseri umani, seppure, allo stesso tempo, le loro decisioni influenzano profondamente la realtà.

Il problema della responsabilità diventa ancora più pressante quando parliamo di sistemi di IA che si auto-apprendono. Questi sistemi non sono limitati a eseguire compiti pre-programmati, ma imparano e modificano il loro comportamento in base ai dati che raccolgono. In tali contesti, non è più facile risalire a un’unica persona o ente responsabile. La responsabilità si diffonde tra chi ha progettato l’algoritmo, chi lo ha addestrato, chi lo ha utilizzato e lo stesso sistema, che opera in modo semi-autonomo.

L’accesso e il controllo delle tecnologie digitali e dell’Intelligenza Artificiale sollevano questioni di giustizia e potere. Chi detiene il potere di plasmare la realtà attraverso questi strumenti? Il controllo delle piattaforme digitali, dei dati e degli algoritmi è oggi nelle mani di poche grandi multinazionali. Questo crea una concentrazione di potere senza precedenti, poiché coloro che controllano la tecnologia hanno anche la capacità di modellare l’esperienza della realtà di miliardi di persone.

Questa dinamica introduce una disuguaglianza strutturale tra chi possiede i mezzi per influenzare e creare la realtà e chi subisce tale influenza. Non tutti hanno accesso agli strumenti per comprendere o partecipare attivamente alla costruzione della realtà digitale, il che porta a nuove forme di alienazione. Si sta creando una divisione tra chi può “governare” il mondo digitale e chi ne è semplicemente un consumatore passivo.

L’AI e le tecnologie digitali mettono in crisi anche il concetto di identità personale e autenticità. Nella società digitale, la nostra identità non è più solo il risultato di un’esperienza di vita diretta, ma è modellata dalle nostre interazioni virtuali, dai dati che generiamo e dalla rappresentazione di noi stessi che costruiamo online. Se la nostra immagine digitale può essere manipolata, replicata o addirittura migliorata da tecnologie come la realtà aumentata o i deepfake, la domanda diventa: cosa significa essere autentici? La nostra identità rimane la stessa nel mondo digitale o diventa fluida, adattabile e malleabile? Inoltre, l’esistenza di avatar virtuali o repliche digitali di sé potrebbe condurre a una frammentazione dell’identità personale, dove una persona “esiste” simultaneamente in più forme e in più luoghi, in un modo che sfida la comprensione tradizionale dell’essere umano come entità unica e indivisibile.

Un ulteriore rischio legato all’AI la disumanizzazione. Se le tecnologie assumono un ruolo sempre più centrale nella nostra vita, potremmo iniziare a vedere il mondo attraverso una lente algoritmica. Questo non solo riduce la nostra esperienza a un insieme di dati, ma potrebbe portare a un allontanamento dagli aspetti più profondi dell’esperienza umana, come l’empatia, la creatività e la morale. In un mondo dove le decisioni importanti sono affidate a sistemi artificiali c’è il rischio di una progressiva perdita della nostra capacità di giudizio morale e di interazione autentica con gli altri.

Le IA, basate su processi statistici e algoritmici, possono mancare di comprensione delle sfumature etiche o emotive delle decisioni umane. Questo rischia di ridurre la complessità della vita umana a qualcosa di troppo semplificato, con gravi conseguenze per la società. In alcuni contesti, come il lavoro o la giustizia, si potrebbe vedere una riduzione delle persone a meri numeri, valutate non per il loro valore intrinseco, ma per ciò che i dati e gli algoritmi dicono di loro.

Le implicazioni etiche e filosofiche del cambiamento ontologico della realtà, causato dal digitale e dall’AI, sono profondamente complesse. La ridefinizione della realtà attraverso questi mezzi ci pone di fronte a dilemmi che riguardano non solo la verità e la giustizia, ma anche la nostra stessa comprensione dell’essere umano. La tecnologia non è più semplicemente uno strumento che usiamo: è diventata una forza attiva nel determinare cosa sia reale, chi siamo e come interagiamo con il mondo. Di fronte a questa rivoluzione, dobbiamo riflettere su come mantenere una dimensione autenticamente umana e morale all’interno di una realtà sempre più tecnologicamente mediata.

La caratteristica distintiva dell’AI rispetto al Leviatano di Hobbes risiede nella sua decentralizzazione. Mentre il Leviatano è rappresentato come un’entità singola e sovrana, che detiene tutto il potere, l’autorità dell’AI è distribuita attraverso una rete di attori. Questa rete include governi, aziende tecnologiche e sviluppatori indipendenti, che detengono diverse forme di potere regolatorio. Il controllo dell’AI, dunque, non è concentrato in un’unica figura sovrana, ma frammentato e diffuso attraverso un complesso sistema di governance algoritmica. Questo cambia radicalmente il modo in cui dobbiamo pensare al potere nell’era digitale.

La caratteristica distintiva dell’AI rispetto al Leviatano di Hobbes risiede nella sua decentralizzazione. Mentre il Leviatano è rappresentato come un’entità singola e sovrana, che detiene tutto il potere, l’autorità dell’AI è distribuita attraverso una rete di attori. Questa rete include governi, aziende tecnologiche e sviluppatori indipendenti, che detengono diverse forme di potere regolatorio. Il controllo dell’AI, dunque, non è concentrato in un’unica figura sovrana, ma frammentato e diffuso attraverso un complesso sistema di governance algoritmica. Questo cambia radicalmente il modo in cui dobbiamo pensare al potere nell’era digitale.

Il Novum Organum, pubblicato nel 1620, costituisce, senza dubbio, una pietra miliare nella storia del pensiero scientifico e filosofico. Francis Bacon, in quest’opera, non solo critica i metodi di conoscenza allora dominanti, ereditati dalla tradizione aristotelica e scolastica, ma propone anche un nuovo metodo, basato sull’induzione e sulla sperimentazione empirica. La sua visione mira a riformare il processo di acquisizione della conoscenza per avanzare nel progresso tecnico e scientifico.

Il Novum Organum, pubblicato nel 1620, costituisce, senza dubbio, una pietra miliare nella storia del pensiero scientifico e filosofico. Francis Bacon, in quest’opera, non solo critica i metodi di conoscenza allora dominanti, ereditati dalla tradizione aristotelica e scolastica, ma propone anche un nuovo metodo, basato sull’induzione e sulla sperimentazione empirica. La sua visione mira a riformare il processo di acquisizione della conoscenza per avanzare nel progresso tecnico e scientifico.